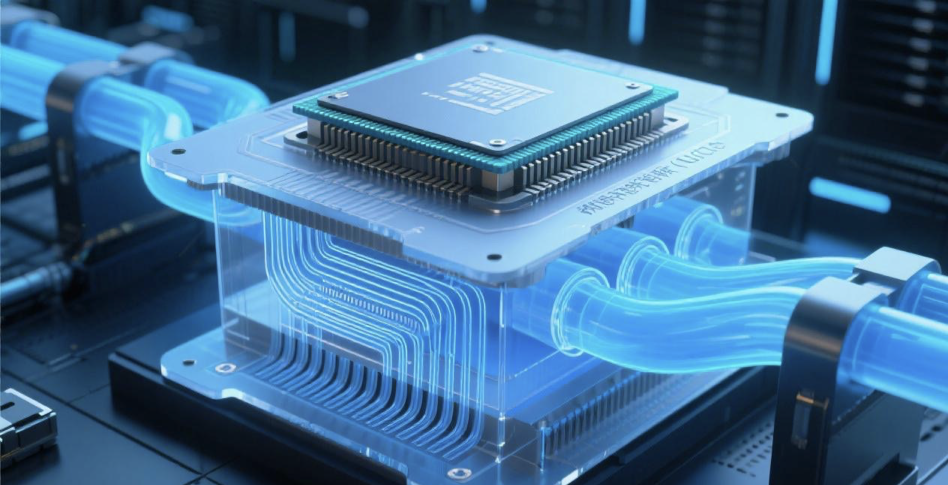

台湾经济日报9月15日报道,英伟达AI新平台Rubin与下一代Feynman平台的功耗预计高达2000W以上,现有的散热方案无法应对,传出英伟达要求供应商开发全新的“微通道水冷板MLCP”技术,该技术把多种散热元件深度整合,单价是现有散热方案的3-5倍,液冷板、均热板散热组件跃居变成战略物资,蓄势进入英伟达「冷革命3.0」时代。

图片:AI生成

什么是MLCP液冷?

-

高度集成化:将均热板(Vapor Chamber)、水冷板、IHS封装顶盖乃至芯片裸晶进行高度整合,极大减少了传统散热模组中的接触界面和热阻; -

微米级水道:传统液冷板的微水道尺寸在0.1mm (100μm) 到数毫米水平,而MLCP的通道尺寸可降低至微米级别,显著增大了换热面积,提升了散热效率。 -

超高热流密度处理能力:MLCP能够处理超过2000W的热功耗,以及超过1kW/cm²的极端热流密度; -

显著提升散热效率:通过优化设计和微通道结构,能大幅降低热阻(可低至0.02°C·cm²/W)使芯片能在更低温、更稳定的状态下运行,从而提升计算性能和可靠性。

|

特性 |

传统风冷 |

传统液冷(液冷板) |

MLCP(微通道液冷板) |

|

最大支持TDP |

< 500W |

500W - 1000W |

> 2000W |

|

典型热阻 |

> 0.20 °C·cm²/W |

0.10—0.20 °C·cm²/W |

< 0.05 °C·cm²/W |

|

相对成本 |

1x (基准) |

2x~4x |

6x~10x |

|

主要限制 |

噪音大,机柜功率密度低 |

接触热阻较高 |

制造复杂,良率挑战 |

冷革命3.0时代:MLCP液冷以及更高效液冷技术

MLCP成散热新战场

|

项目 |

内容 |

|

新架构推进 |

英伟达从GB200切换到GB300,并提前布局Vera Rubin世代,散热全面走向液冷 |

|

MLCP需求 |

Rubin GPU功耗上修至2.3kW,冷板已难负荷,最快2026年下半年导入MLCP(微通道盖板) |

|

产业进度 |

台湾散热三雄已有业者完成MLCP样品送样,但仍面临良率、渗漏与整合挑战,量产时间需3~4季 |

|

市场影响 |

散热大厂具CoWoS盖板独家地位,若全面转向MLCP,成本将比Blackwell方案高5~7倍,带动价值链重组 |

|

短期策略 |

在MLCP落地前,冷板仍是主流,GB300出货持续推升营运,各厂同步卡位微通道机会 |

资料来源:采访整理制表:杨络悬

资料来源:台湾经济日报、财联社、以及网络资料等。

|

序号 |

演讲议题 |

拟邀企业 |

|

1 |

AI算力服务器散热技术发展新趋势 |

液冷服务器/解决方案企业 |

|

2 |

AI芯片级液冷散热技术 |

液冷服务器/解决方案企业 |

|

3 |

新一代液冷技术介绍及其发展趋势 |

液冷服务器/解决方案企业 |

|

4 |

冷板式液冷CDU及多元配套方案 |

液冷服务器/解决方案企业 |

|

5 |

浸没式液冷技术的创新与挑战 |

液冷服务器/解决方案企业 |

|

6 |

开放多算力兼容液冷整机柜服务器架构演进思考 |

液冷服务器/解决方案企业 |

|

7 |

准入与生态协同:共建液冷产业生态 |

液冷服务器/解决方案企业 |

|

8 |

液冷技术发展如何赋能高密算力部署 |

数据中心终端应用企业 |

|

9 |

数据中心液冷解决方案分享与节能设计 |

数据中心终端应用企业 |

|

10 |

AI算力服务器/数据中心液冷系统的设计与开发 |

数据中心终端应用企业 |

|

11 |

液冷系统管路设计与制造 |

管道供应企业 |

|

12 |

快速插拔接头如何赋能液冷技术的规模化应用 |

UQD供应商 |

|

13 |

新型液冷技术在储能行业中的创新发展 |

储能行业 |

|

14 |

液冷系统智能运维与可靠性管理 |

运维系统厂商 |

|

15 |

新一代储能电池液冷板的设计与开发 |

新能源车企、电池厂商 |

更多议题征集中,创新演讲及赞助请联系:Elaine:13418617872(同微信)

方式1:请加微信并发名片报名

电话:Elaine:13418617872(同微信)

邮箱:ab052@aibang.com

扫码添加微信,咨询会议详情

注意:每位参会者均需提供信息

方式2:长按二维码扫码在线登记报名

或者复制网址到浏览器后,微信注册报名:

https://www.aibang360.com/m/100274?ref=172672

微信扫描下方的二维码阅读本文

- 热交换核心 :冷板(CPU/GPU专用)、CDU(冷量分配单元);

- 循环网络 :Manifold分液器、EPDM/PTFE管路、快接头;

- 动力与控制 :变频循环泵(如飞龙股份电子泵)、智能温控系统。