→ 发展历程与定义

计算机液冷技术并非新概念,其雏形可追溯至20世纪60年代,并于1973年由贝尔实验室的E . Baker 在一篇论文中首次提出了这一技术。20世纪80年代中期开始,个人电脑的普及推动了散热解决方案的工业化,但当时业界更青睐结构简单、适用性更强的风冷方案。

然而,随着时间的推移,计算能力呈指数级增长和组件的小型化发展,设备功率密度急剧攀升,导致发热量激增与散热难度加大。如今,单个服务器机架的功率已从过去的不足10kW/机架飙升至30kW/机架,在超算(HPC)等场景中甚至达到100-120kW/机架——这相当于过去一家中型企业运营的数据中心的总功率。此类高功率应用(如高校超级计算机、气象学、公司科学计算等)目前均采用液冷方案,这些解决方案通常具有特定的设计并且不是市售产品。

艾邦建有服务器液冷散热交流群,欢迎大家加入我们,共绘服务器液冷散热未来!

→ 行业关注度提升

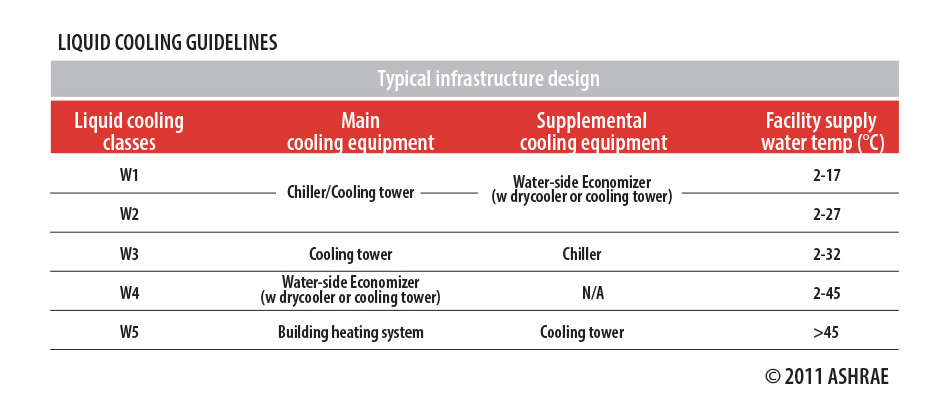

2011年,ASHRAE TC 9.9委员会将液冷技术纳入《热指南》,这份影响深远的文件为数据中心散热设计提供了能效优化标准。该委员会发布的一份白皮书,使液冷技术再次受到关注,该白皮书探讨了液冷技术在常规数据中心而非特殊应用领域的渗透。

通常,CPU集中了设备80%的发热量,内部温度不得超过一定值(通常为 70-80°C),否则处理器将因过热而逐渐停止工作。因此,散热冷却必不可少的。

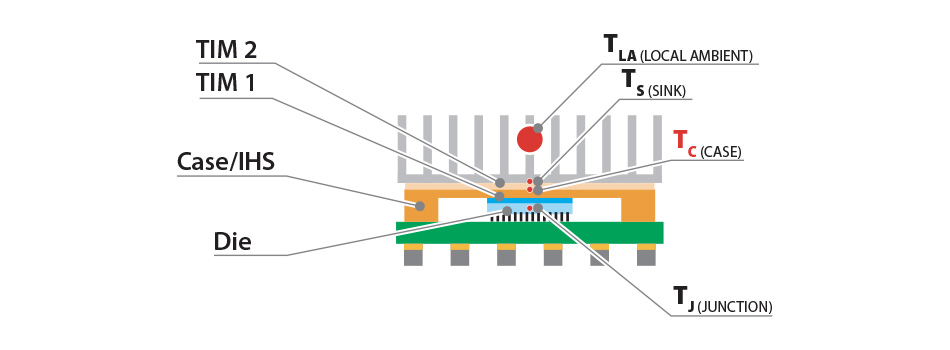

下图显示了在微芯片级别识别的各种温度,ASHRAE 使用 TC 或外壳温度作为参考,因为外壳通常与风冷翅片式散热器接触。除了此参数外,还参考了“socket power”或设备(无论是 CPU、GPU还是其他设备)的输入功率。

→ 测量散热难度系数

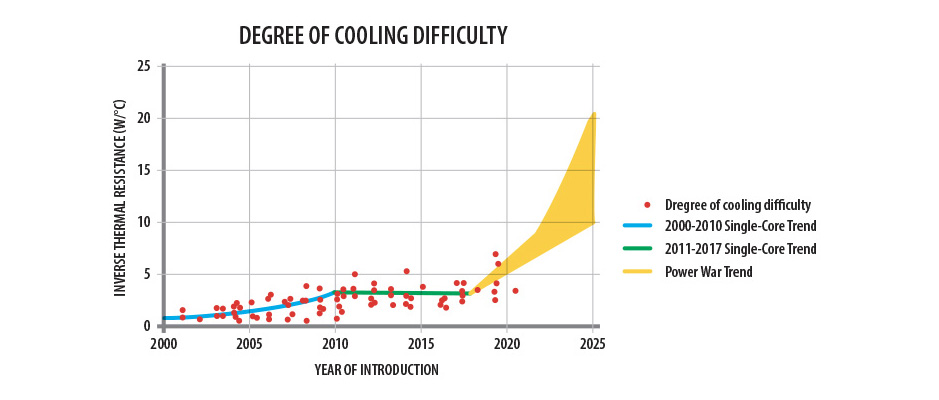

以上两个值一起用于定义一个指标,表示微处理器散热的难易程度;这被称为“热阻”,本质上是正常运行时外壳和冷却介质之间的温差与输入功率的比率。它的倒数通常用作表示在相同温差下需要耗散多少功率的度量。因此,值越高,表示需要耗散的功率越大,因此根据已知的热交换定律,需要的热交换表面或系数就越高。设备的小型化限制了散热面积扩展,因此只能提升表面换热效率。而若不过多涉及技术细节,液体的表面换热效率远超空气。

上图表呈现了过去二十年不同设备的典型变化趋势。值得注意的是,根据ASHRAE数据,散热难度经历了三个阶段:第一阶段持续攀升,直至 2010 年,随后由于“多核”技术的引入而趋于稳定,该技术通过增加处理器数量来提升算力,同时扩大散热面积,使得散热难度维持稳定。而近期单核功率的激增则导致散热难度再度快速上升。因此,ASHRAE 预计液体冷却的使用将会增加,因其在相同散热面积下效能显著优于风冷(根据 Gartner 的数据,最高可达 3000 倍)。

→ 液冷形式多样

当前液冷技术方案主要分为三类:

-

间接液冷(ILC):在机箱内安装支撑服务器的液冷板;

-

直接液冷(DLC):使用与 CPU 外壳接触的特定液体热交换器代替翅片散热器;

-

全浸没液冷(TLC):将服务器浸入绝缘冷却液中。

其中浸没式方案催生了新型冷却液的研发需求——既要保证换热性能,又要确保电气安全性(如避免使用水基溶液)及环保性。双相变系统通过冷却液汽化-冷凝循环实现高效换热,虽需复杂管路设计,却能减少昂贵冷却液的用量。

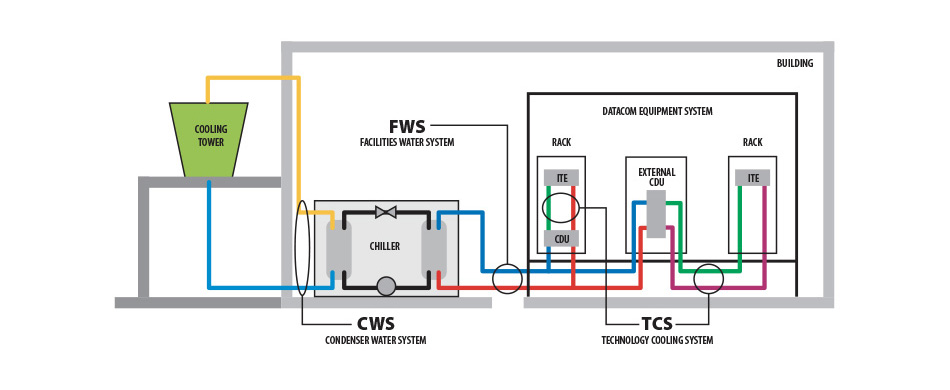

ASHRAE 和 OCP(开放计算项目)都报告了一种相对完整的参考布局,如下所示。图中突出显示了主流体回路,通过冷却分配单元 (CDU) 使用二次流体进行热交换,二次流体可以是冷水机组或蒸发塔冷却的水。

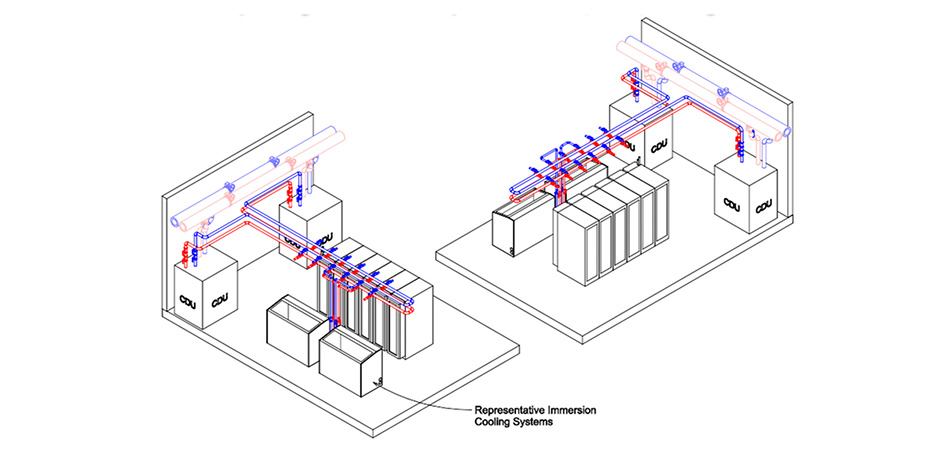

下图展示浸没式/机架级系统:

图片来自:

https://www.opencompute.org/documents/ocp-acf-reference-design-guidance-white-paper-pdf-1

芯片温度通常在55-60°C左右,因此,采用液体冷却技术,流体温度可达到45-50°C,只需使用散热器和室外空气即可冷却,从而显著节省能源。由此获得的温度还可以回收热量,用于冬季供暖或工业生产,欧洲能源效率组织(EPEE)正推动将此类余热回收技术纳入标准。ASHRAE根据允许的流体温度对系统性能进行分类,因此取决于系统类型。

然而,正如2021年发布的上述白皮书中所强调的那样,这些等级目前正在修订,由于密度和冷却难度的增加,限制降低了 2°C。

→ 结论

液冷具有节省空间、降低噪音(无风扇)等优势,但其系统高成本、操作门槛及供应链成熟度限制了普及速度——尤其在以新建数据中心速度为竞争关键的扩张期。尽管如此,由于液冷技术具有诸多优势,领先的服务器制造商现在已经实现了液体冷却解决方案的工业化,特别是 DLC,它可以在冷却 CPU 的同时保持标准机架布局,可减少80%的风冷需求。

行业普遍认为液冷将逐步替代传统方案,它也可以与其他系统结合使用,衍生出"混合冷却"新模式:在散热难度持续增加的背景下,部分场景仍保留机械制冷(冷水机组)以控制进口温度。

文章来源:CAREL INDUSTRIES SpA

原文链接:https://www.carel.com/blog/-/blogs/liquid-cooling-for-data-centres-from-niche-to-mainstream-?utm_source=twitter

封面图源:易飞扬通信

艾邦建有服务器液冷散热交流群,聚焦服务器液冷技术前沿,涵盖冷板/浸没/喷淋式方案设计、材料升级(耐腐蚀管路、密封件创新)、CDU运维与能效优化、政策标准解读(PUE、OCP规范)等。欢迎大家加入我们,共绘服务器液冷散热未来!

微信扫描下方的二维码阅读本文

- 热交换核心 :冷板(CPU/GPU专用)、CDU(冷量分配单元);

- 循环网络 :Manifold分液器、EPDM/PTFE管路、快接头;

- 动力与控制 :变频循环泵(如飞龙股份电子泵)、智能温控系统。