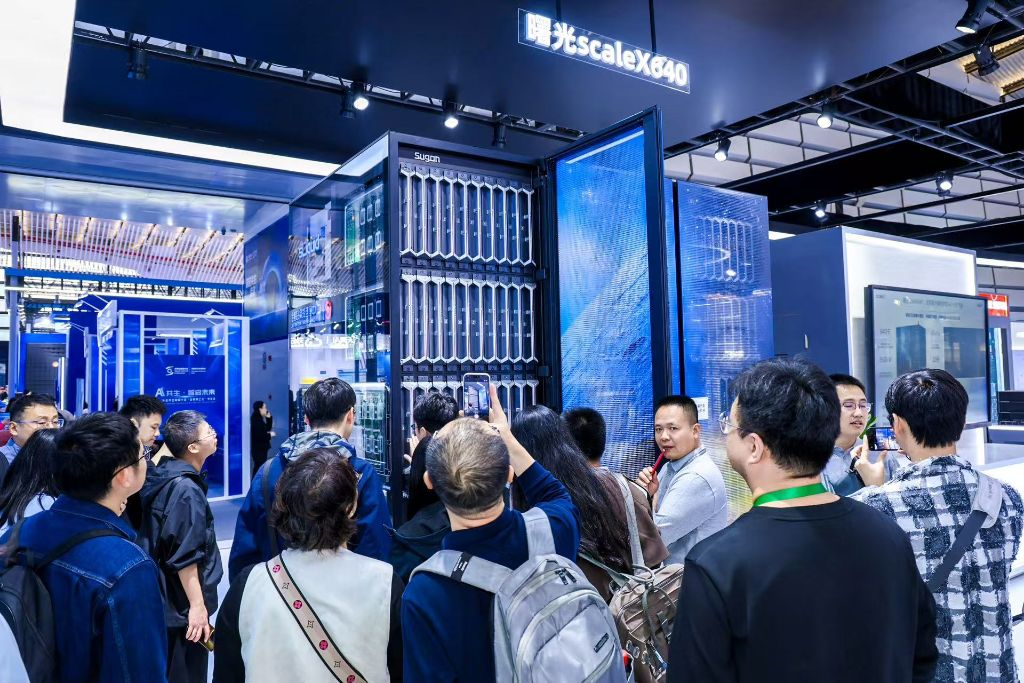

AI界流传甚久的超高密度超节点传闻,在乌镇世界互联网大会上得到了证实!

在此次大会上,中科曙光正式推出了scaleX640超节点。官方信息透露,相比业界同类产品,其综合算力性能实现倍增,单机柜算力密度可提升20倍,并能以双scaleX640超节点装配千卡级计算单元,支持百万卡规模拓展。

比起性能参数更值得关注的是这款产品令人惊叹的生态兼容性——它在硬件范畴支持“多品牌加速卡”,在软件相关层面“实现主流AI计算生态兼容”。scaleX640超节点为陷入发展瓶颈的国产AI算力,构建了一个真正好用的“算力底座”。

(scaleX640超节点备受关注)

艾邦建有服务器液冷散热交流群,聚焦服务器液冷技术前沿,涵盖冷板/浸没/喷淋式方案设计、材料升级(耐腐蚀管路、密封件创新)、CDU运维与能效优化、政策标准解读(PUE、OCP规范)等。欢迎大家加入我们,共绘服务器液冷散热未来!

国产AI为何需要万卡超节点?

若要明白曙光scaleX640超节点的战略意义,首先得回应一个问题:国产AI为什么急切需求千卡、以及万卡级的计算单元?

答案很简单:国产AI正面临“单芯片性能不强”与“大模型需求激增”的双重挑战。

当前,国产AI单芯片的性能跟国际一流水平存在一定距离;而万亿参数大模型又成了AI竞赛的“敲门砖”,其训练和推理阶段对算力的需求呈指数级增长。在此背景下,破局关键在于系统集成创新——通过集群规模效益弥补单卡性能不足,将成千上万张加速卡高效协同,构建万卡级乃至百万卡级超大规模集群,已成为国产AI突破算力瓶颈的必然路径。

最新发布的《2025中国算力发展之AI计算开放架构研究报告》指出,国内AI产业的破局路径,需要“以集群规模效益弥补单卡性能代差”,而曙光scaleX640超节点正是这一理念的现象级产品。

但要实现“集群规模效益”目标,绝非“10000张卡堆在一起”而是需要冲破三个“关键瓶颈”:

1、供电与散热:“千卡”集群的功耗规模十分庞大,一个机柜的用电功率甚至比得上一座楼宇,传统风冷散热模式在此已彻底失效。

2、高速通信: 怎样使海量“加速卡”实现相互高速通信且低延迟?若不能实现卡间的高速通信,AI集群规模越大效率则会大打折扣。

3、生态协同:在传统封闭体系下,不同品牌加速卡与软件栈互不兼容,形成一座座“生态孤岛”,这使得统一的资源调度、高效的算力协同成为几乎不可能完成的任务,也正是国产AI算力发展的核心痛点。

这三道“瓶颈”,最终形成了“物理极限”与“生态割裂”两大核心挑战。而中科曙光scaleX640超节点,则通过“系统工程创新”以及采用“开放计算架构”,解决了上述三大难题。

曙光方案:筑就国产AI高效算力底座

面对“物理极限”与“生态割裂”等多重挑战,曙光scaleX640超节点价值,不在于算力卡简单堆砌,而在于集群架构创新与开放生态设计。通过系统级工程突破,它为国产AI筑就了高效统一算力底座。

“高效节能”:scaleX640通过“浸没相变液冷”+“高压直流供电”,实现相比传统风冷模式30%的节能效率,并全面释放算力设施潜能,这是实现“单机柜640卡”超高算力密度的“物理要素”。

(scaleX640超节点液冷技术特写)

“高速互联”:以“超高速正交架构”配合“超高密度刀片”为依靠,这就是scaleX640超节点的“神经体系”,它实现出“单机柜640卡超高速总线互连”,构建出“大规模、高带宽、低时延”的通信范围,并可保障百万卡级超大规模集群的扩展部署。 “生态协同”:依靠“AI计算开放架构”,在硬件层面支持多品牌加速卡,软件层面兼容主流计算生态,构建了一个“软硬协同、生态兼容”的国产智算新范式。

艾邦建有服务器液冷散热交流群,聚焦服务器液冷技术前沿,涵盖冷板/浸没/喷淋式方案设计、材料升级(耐腐蚀管路、密封件创新)、CDU运维与能效优化、政策标准解读(PUE、OCP规范)等。欢迎大家加入我们,共绘服务器液冷散热未来!

资料来源:https://mp.weixin.qq.com/s/keubE9ke3HyHJcHEUe6hig?poc_token=HIO2FWmjfCf6Opi4_nBeyJkJvofU-gBFwUtaBudW

微信扫描下方的二维码阅读本文

- 热交换核心 :冷板(CPU/GPU专用)、CDU(冷量分配单元);

- 循环网络 :Manifold分液器、EPDM/PTFE管路、快接头;

- 动力与控制 :变频循环泵(如飞龙股份电子泵)、智能温控系统。