液冷对于AI,为何是“刚需”?

| 文章来源:数智前线

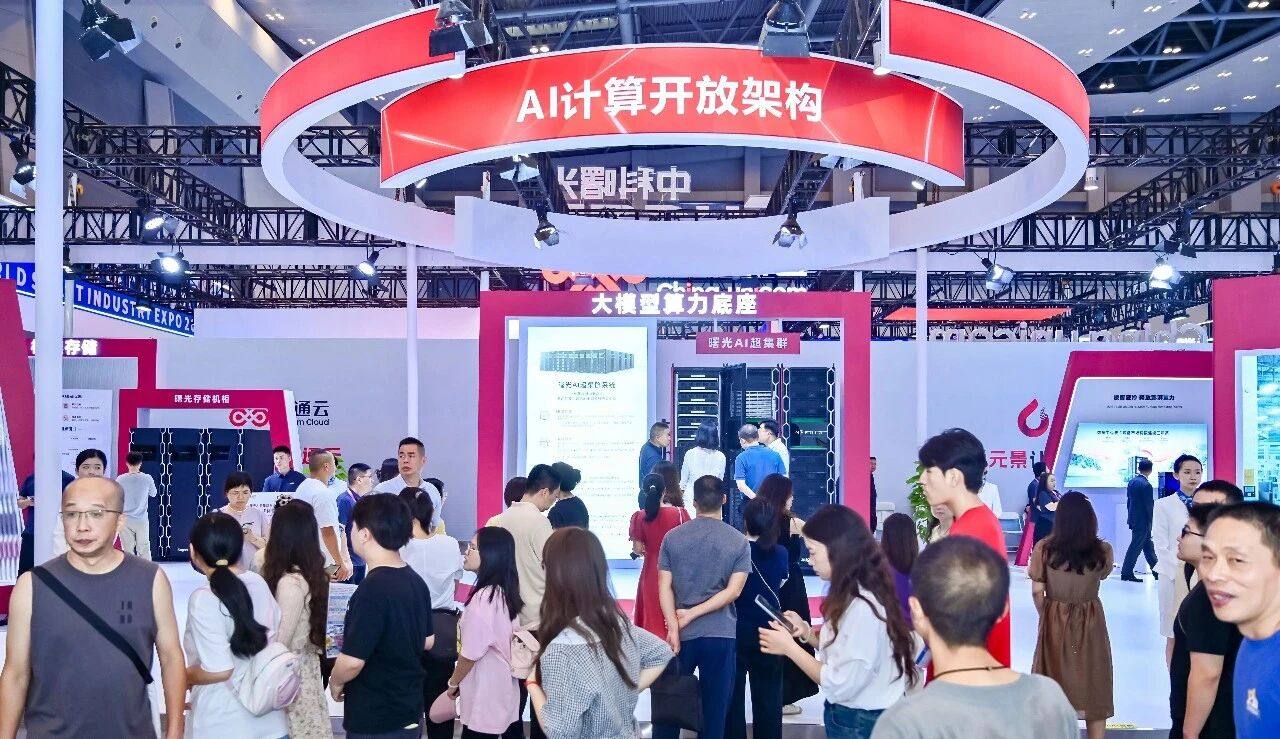

在2025年世界智能产业博览会上,中科曙光联合20余家上下游企业,共同发布了国内首个AI计算开放架构、同步推出基于该架构的AI超集群系统,并依托国家先进计算产业创新中心启动“AI计算开放架构联合实验室”。该超集群将为万亿至十万亿级参数大模型训练提供贴身服务,同时支撑并发式推理与全新科研范式场景。

在这一架构中,液冷被明确为AI基础设施的关键能力。在近几年AI加速演进的浪潮中,算力基础设施正从“硬件堆叠”迈向“系统协同”。液冷在这一转型中被重新定义,不再是单一散热组件,而是“算-存-网-电-冷”一体化系统中的关键底座。

要让液冷真正走向普惠,唯有拥抱标准开放与生态协同。开放架构正成为推动液冷从“定制化”走向规模化、普惠化的核心路径。谁能率先构建可持续的液冷生态,谁就将在下一代AI基础设施的竞争中赢得先机。

01

液冷,正成为AI关键变量

在国家深入实施人工智能+过程中,AI大模型迎来爆发期。今年,万亿参数MoE模型、深度推理模型、多模态模型已成为市场焦点;各行业加快落地人工智能,行业大模型爆发,多智能体协作兴起,具身智能热带动了世界模型训练热潮,这些都推动算力需求激增。2025年中国智算规模将达到1000EFLOPS。

传统单机、单卡性能已难以满足这样的算力爆发,产业转向发展更大规模、更高效率的AI集群。通过系统级优化,弥补单卡性能差距,已成为行业共识。

AI集群规模快速扩大的同时,风冷已接近极限。“液冷技术对于AI,尤其是万卡、十万卡的大集群,是一个刚需。”曙光数创副总裁兼CTO张鹏在智博会上说道。

这种转变极为迫切。AI集群的密度蹿升,机柜功率普遍突破80kW,甚至超过100kW,传统风冷在40kW以上便难以应对。同时,GPU功耗已超过1000瓦,并迈向2000瓦、3000瓦,风冷难以支撑。散热跟不上导致GPU空闲、电费飙升。相比之下,液冷有更高效的冷却能力。此外,液冷具备显著能效优势,传统风冷PUE通常在1.3~1.6之间,意味着每带走100个单位热量,需额外花费30到60个单位热量。而曙光数创的液冷方案目前可将PUE降至1.04,每百单位热量仅需4单位能耗,节能效益可观。

进一步来说,AI行业迭代越来越快,大模型训练周期已从“月级”压缩到“天级”,推理也需支撑低延迟、高并发要求,对存算一体等提出高要求。在这种情况下,液冷已不仅是技术选型,更是面向未来AI基础设施的战略选择,散热不再是一个“后勤问题”,而成为直接决定AI算力利用率和投资回报的核心变量。

为此,国际大厂如Meta、微软已启动浸没式液冷部署试点。国内中国移动、阿里等也在布局液冷数据中心。其中,中国移动呼和浩特建成全球最大单体液冷智算中心,阿里仁和数据中心为全球最大全浸没式液冷部署。工信部等多部门出台各项政策,推动液冷标准制定和落地应用。

然而,液冷技术虽然早就存在,过去却难以走向大规模落地,主要受制于成本高、标准缺、运维复杂、安全性不足等问题。业内意识到,液冷落地的最大障碍,已不再是单点技术能力,而是生态体系的协同水平。

曙光数创作为国家先进计算产业创新中心AI开放架构联合实验室的重要参与方,承担起液冷技术标准化与生态构建的责任。从开放架构出发,曙光数创聚焦液冷标准建设、组件通用与生态协同,破解液冷过去“各自为政、自研闭环”形成的生态孤岛问题,推动生态链融合,为液冷突围,成为普惠AI基础设施奠定基础。

02

液冷生态,从理想走进现实

在最新发布的AI超集群中,选择了曙光数创的冷板液冷技术,作为系统向高密、高效演进的重要支撑。

该方案不仅提升了系统的性价比,也借助其技术成熟度和开放架构理念,吸引更多合作伙伴加入生态共建。同时,通过芯片、整机到系统层的功耗协同管理,实现集群能效的全面提升。

实际上,作为国内最早布局液冷的企业之一,曙光数创自2011年开始布局液冷,2015年量产TC40冷板液冷服务器,2017年落地512节点液冷集群。长期服务大型机和高端计算系统的经验,使其在液冷系统与整机系统融合方面具备深度的积淀,也为其推动液冷走向标准化、规模化落地,奠定基础。

围绕开放需求,曙光数创在冷板液冷方案中实现了“服务器与机柜解耦”、“模块化总线设计”和“盲插接口”等能力,支持分阶段升级,兼容不同品牌型号设备,实现快速部署,提升运维效率超30%。面对更高热通量挑战,今年推出的C7000-F相变间接液冷方案,首次实现该技术产品化落地,自研环保冷媒SFP-1025F,绿色高效、能长期稳定运行,解决了传统液冷在水质与安全方面的顾虑,满足AI服务器高强度运行需求。

在实现冷板液冷大规模应用的同时,曙光数创牵头编制《数据中心冷板式液冷系统技术规范》国家标准,联合运营商、互联网企业等头部单位共建液冷生态,形成从芯片散热、服务器制造到冷却系统集成的完整液冷技术应用链条,助力液冷市场规模化发展。下一阶段,曙光数创将开放浸没式液冷技术,促进领先技术普及。

03

液冷“开放之路”,重塑AI算力底座

在AI基础设施走向“系统协同”后,液冷的角色正在被重新定义,从单一的散热组件,跃迁为支撑系统协同的关键底座能力。它要融入整个AI平台的协同、能效调度、运维体系,成为支撑存算一体、绿色智算多元场景的系统组成部分。

然而,液冷的普及之路并不轻松。多厂商各自为政,接口标准不统一、系统封闭难兼容,导致液冷长期停留在“小规模、定制化”阶段。唯有推动标准开放、生态协同,才能打破“冷却孤岛”。

业界看到,液冷的开放之路,是一条“难而正确”的道路。它不仅是产业演进的必然逻辑,更是国家AI战略实现普惠算力的时代选择。谁能率先构建起繁荣且可持续的液冷生态,谁就能在下一代AI基础设施竞争中占据战略高地。

以曙光发布的AI计算开放架构为契机,液冷正加速迈向标准化与开放化。在2025智博会“开放普惠智能计算生态”论坛上,曙光数创CTO张鹏表示,曙光数创正在通过能力开放、标准共建、跨界融合等模式,积极推动液冷生态体系建设。

依托长期对液冷技术的积累与开放架构的推进路径,曙光数创正引领中国液冷技术从实验室走向规模化落地,推动AI基础设施走向更加开放和普惠的新阶段。

文章来源:中科曙光行业深度 | 液冷不再“冷”,它正成为AI开放底座关键变量 (qq.com)

微信扫描下方的二维码阅读本文

- 热交换核心 :冷板(CPU/GPU专用)、CDU(冷量分配单元);

- 循环网络 :Manifold分液器、EPDM/PTFE管路、快接头;

- 动力与控制 :变频循环泵(如飞龙股份电子泵)、智能温控系统。